Search Engine Optimizing für philatelistische Webseiten

Teil 1 - Die Online Tools

Autor: Stephan Jürgens, AIJP

Autor: Stephan Jürgens, AIJP

Ich betreibe seit einigen Jahren eine philatelistische Webseite (www.bollatrice.de) mit der ich auch schon an philatelistischen Literaturausstellungen teilgenommen habe. Diese Teilnahmen sind einigermassen erfolgreich gewesen, sprich die erreichten Punktzahlen und Medaillen lagen über dem Durchschnitt der anderen Wettbewerbsteilnehmer.

Im Rahmen dieser Wettbewerbsteilnahmen ist mir aufgefallen, dass sich die Besuche von SEO Agenturen auf meiner Webseite häuften. Mein Webhoster stellt(e) eine Besuchstatistik bereit, die für viele Besuche die "referrierende" Webseite angibt, d.h. die Webseite, die der Besucher zuvor besucht hatte.

Kürzlich haben die Philaseiten eine etwas ältere "Handreichung" aus der Feder von Michael Lenke und Lars Böttger veröffentlicht (Thema: Ausstellungen: Bewertungskriterien für elektronische Datenträger und Internetseiten), die meinen Verdacht bestätigt: die Juroren der philatelistischen Literaturausstellungen benutzen SEO-Werkzeuge1 zur Beurteilung von Webseiten. Die offiziellen Bewertungsrichtlinien des BDPh, welche auch im Internet veröffentlich sind (hier), sind nicht so deutlich, geben im Bereich "Zugänglichkeit" aber auch zwei Werkzeuge an, die dem SEO-Bereich zuzuordnen sind2. Alles in allem also genug Gründe für einen philatelistischen Webseitenbetreiber, sich ein wenig mit SEO zu beschäftigen.

Suchmaschinenoptimierung ist natürlich nicht die Optimierung der Suchmaschine, sondern die Kunst, die eigenen (oder gegen Bezahlung auch fremde) Webseiten in den Suchergebnissen nach "oben" zu bringen. Insbesondere letzteres kollidiert natürlich mit den Geschäftsinteressen der Suchmaschinenbetreiber, deren "Kapital" im wesentlichen darauf beruht als "ehrlicher Makler" die möglichst am besten zum Suchwort passenden Webseiten auszuwählen. Dass die Suchmaschinenbetreiber sich dieses "Kapitals" bewußt sind, zeigt nicht nur (teilweise deutliche) Kennzeichnung der Suchtreffer, die als bezahlte Anzeigen in die Ergebnisse eingestreut werden, sondern auch die Tatsache, dass ALLE Suchmaschinenbetreiber in ihren Geschäfts- und Nutzungsbedingungen die Nutzung von SEO-Maßnahmen verbieten. Dass die wichtigsten SEO-Werkzeuge für den Hobby-Webseiten-Betreiber von den großen Suchmaschinenbetreibern (kostenlos) angeboten werden steht hierzu nur scheinbar im Widerspruch. Die Unterscheidung zwischen "weißen" und "schwarzen", zwischen "guten" und "bösen" SEO ist kein Ammenmärchen, sondern dass A und O eines Webseitenbetreibers.

Inhalte natürlich in "maschinenlesbarer Form", denn natürlich können die "Spider" der Suchmaschinenbetreiber nur diese auswerten. D.h. Bilder mit einer sinnvollen, individuellen Bildbeschreibung (auch im "alt"-Tag), "Seitenlayout" besser mit HTML und CSS neu machen statt einfach nur die Ausstellungssammlung auf den Scanner zu legen bzw. die Word-Datei als PDF-Datei zu exportieren. Klar, die PDF-Datei hat erstmal den Vorteil, überall gleich auszusehen - aber gerade hierauf kommt es für die Suchmaschinen nicht an - die haben keine Augen3.

Zu den eigentlichen Inhalten möchte ich Ihnen keine Tipps geben, dies hängt ja auch weitestgehend von den Zielen ab, die Sie mit Ihrer Webseite haben. Wenn Sie "nur mal eben" einen Beleg online stellen wollen, um ihn einem Freund zu zeigen und mit ihm am Telefon darüber zu diskutieren, können Sie sich bei Bildbeschreibung etc natürlich eine ganze Menge von dem sparen, was Sie für einen "Beleg des Monats", denn Sie auf der Vereinswebseite stolz allen Mitgliedern (und der Öffentlichkeit) präsentieren, instinktiv machen werden.

Zur Fehlerfreiheit hingegen einige Anmerkungen: hier geht es auch um Rechtschreibung und Grammatik und nicht nur um technische Fehlerfreiheit. Sicherlich ist Google darin gut, Rechtschreibfehler zu korrigieren, wie jeder weiß, der sich mal bei der Eingabe eines Suchbegriffes vertippt hat, aber für das "Verständnis" der Texte durch die Maschine ist eine korrekte Rechtschreibung und Grammatik wichtig. Dass dies den menschlichen LeserInnen ebenfalls hilft, Ihre Texte zu verstehen, mag dem Techniker als "interessanter Seiteneffekt" erscheinen, dürfte jedenfalls den Zielsetzungen eines Webseitenbetreibers nicht zuwiederlaufen. Vermeiden Sie Fachsprache und Abkürzungen: stärker noch als in den Fachzeitschriften haben Sie im Internet ein Publikum, welches die Fachbegriffe nicht kennt. Und Google und Co. befinden sich intelektuell maxmimal auf dem Niveau des 45. US-Präsidenten. (Mal abwarten, wie lange es dauert, bis Google diesen Satz als Beleidigung Ihrer Suchmaschine auffasst und entsprechend ahndet.)

Eine gute Idee ist es also, die Texte in Word zu schreiben und erst nach erfolgreicher Rechtschreib- und Grammatik-Kontrolle in das HTML-Format umzuwandeln. Ausdrucken und von Menschen Gegenlesen zu lassen, ist natürlich auch eine gute Maßnahme.

Eine Vorbemerkung: die Zielgruppe von SEO-Tools sind Marketing-Spezialisten. Und keines der im folgenden besprochenen Programme und Online-Dienste bietet seine Dienste aus "purer Herzensgüte" an, viele der kostenlosen Programme und Dienste sind eingeschränkte Versionen von kommerziellen Programmen, deren Nutzung teilweise 100 Dollar oder Euro kosten kann. Dies ist prinzipiell nicht verwerflich, aber teilweise sind die kostenlosen Versionen so weit eingeschränkt, dass die Arbeit mit ihnen nicht kostenlos, sondern umsonst ist. Es gibt Dienste, welche die Ergebnisse nur gegen die Angabe einer email-Adresse ausführen bzw. die Ergebnisse nicht auf einer Webseite darstellen, sondern per email verschicken. Da die Auswertung umfangreicher Webseiten durch einige Zeit in Anspruch nehmen kann, ist dies plausibel - wenn dann allerdings nach mehreren Stunden eine Email kommt: "Wir haben 127 Fehler auf Ihrer Webseite gefunden. 1) Sie haben 3 mal "dass" mit ß statt mit ss geschrieben ... 2) Sie haben das 1x Wort "und" verwendet, wollten Sie "und" schreiben ? ... 3) die anderen 123 Fehler teilen wir Ihnen gerne gegen eine Zahlung von xyz mit ..." ist das Gefühl, von einem Bauernfänger verarscht worden zu sein, schon recht ausgeprägt. Benutzen Sie für diese Dienste nur email-Adressen, auf deren regelmässige Lektüre Sie verzichten können, dass sind MARKETING-Profis, denen Sie auch noch die Erlaubnis gegeben haben, Ihnen werbliche Emails zu schicken. Es kann leichter sein, den verwendeten email-account "wegzuwerfen" als sich von den email-Listen und Newslettern wieder auszutragen ...

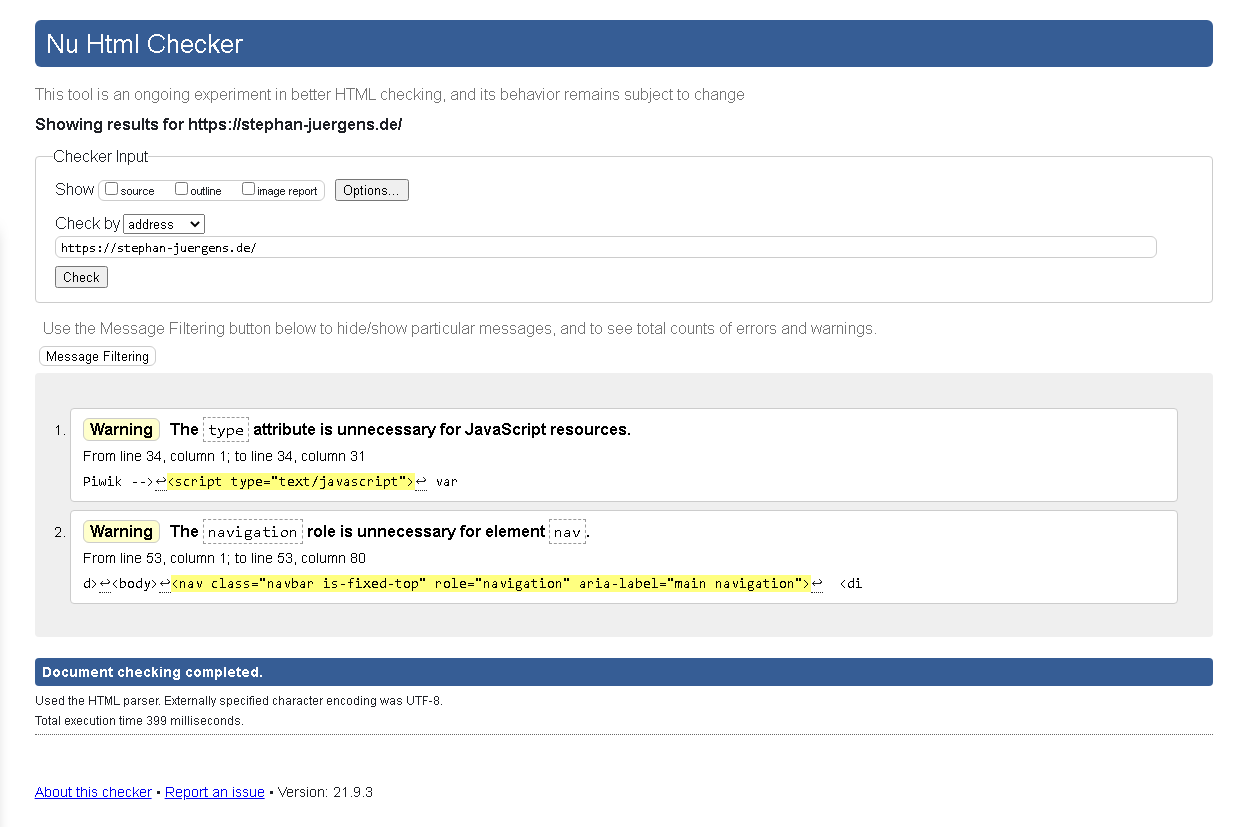

Die BDPh-Richtlinien für Aussteller fordern für Webseiten "eine technisch einwandfreie HTML-Programmierung". Inhaltlich ist diese Forderung völlig OK, denn fehlerfreies HTML ermöglicht es sowohl den Anzeigeprogrammen als auch den Suchmaschinen, die Webseite besser zu verstehen. Die Frage, was "technisch einwandfreies HTML" ist, trifft natürlich das World Wide Web Consortium, das Gremium zur Standardisierung der Techniken im World Wide Web. Dessen "Validator" genannter Service ist im Internet kostenfrei verfügbar - und sollte m.E. die Referenz für alle Bewertungen sein, ob eine Webseite fehlerfrei ist oder nicht.

Screenshot eines Ergebnisses des Validators des W3C zu meiner Webseite.

Bei der Benutzung des Validators bietet es sich an, die Voreinstellung zu benutzen, und den Validator die HTML-Version der zu testenden Webseite bestimmen zu lassen: Browser und Suchmaschinen haben hierfür ja auch keine Hilfestellung durch den Nutzer. Erst wenn die Anzahl der Fehlermeldungen zu hoch ist bzw. man gar nichts versteht, sollte man die gewünschte Version einstellen (d.h. die Version, die man meint programmiert zu haben). Je nach erkannter (oder angegebener) HTML Version verwendet der Validator übrigens unterschiedliche Test-Programme, nicht wundern, wenn Ihr Ergebnis völlig anders aussieht als hier gezeigt. Allen diesen unterschiedlichen Testprogrammen ist aber gemein, dass sie sehr pingelig sind und die gefundenen Fehler nur sehr sparsam erläutern. Googlen des Fehlertextes hilft.

Einige Tipps zum praktischen Umgang mit Validatoren: a) wenn ein Validator z.B. nur einen Fehler findet, und man diesen korrigiert, heißt dass nicht, dass man dann fehlerfrei ist. Der korrigerte Fehler kann andere "versteckt" haben und man kann auch bei der Korrektur selbst einen Fehler gemacht haben. Also auf jeden Fall nochmal testen. b) der W3C Validator testet GENAU eine Seite, Fehler in Unterseiten werden nicht gefunden. Bei Webseiten mit vielen Einzelseiten ist man also lange beschäftigt oder auf "gut Glück" angewiesen. Es gibt kommerzielle Dienste, welche alle Seiten einer Webseite validieren.

Ob man den W3C-Validator als Webmaster philatelistischer Webseiten verwenden muss, bleibt jedem selbst überlassen. Angesichts der Komplexheit (und Pingeligkeit) kann ich jeden Webmaster verstehen, der dieses Tool nicht benutzt, sondern statt dessen zu Alternativen greift. Und für den Juroren ist dieses Tool m.E. nicht brauchbar, da es ihn zwingt, die "Schwere" der Fehler zu beurteilen.

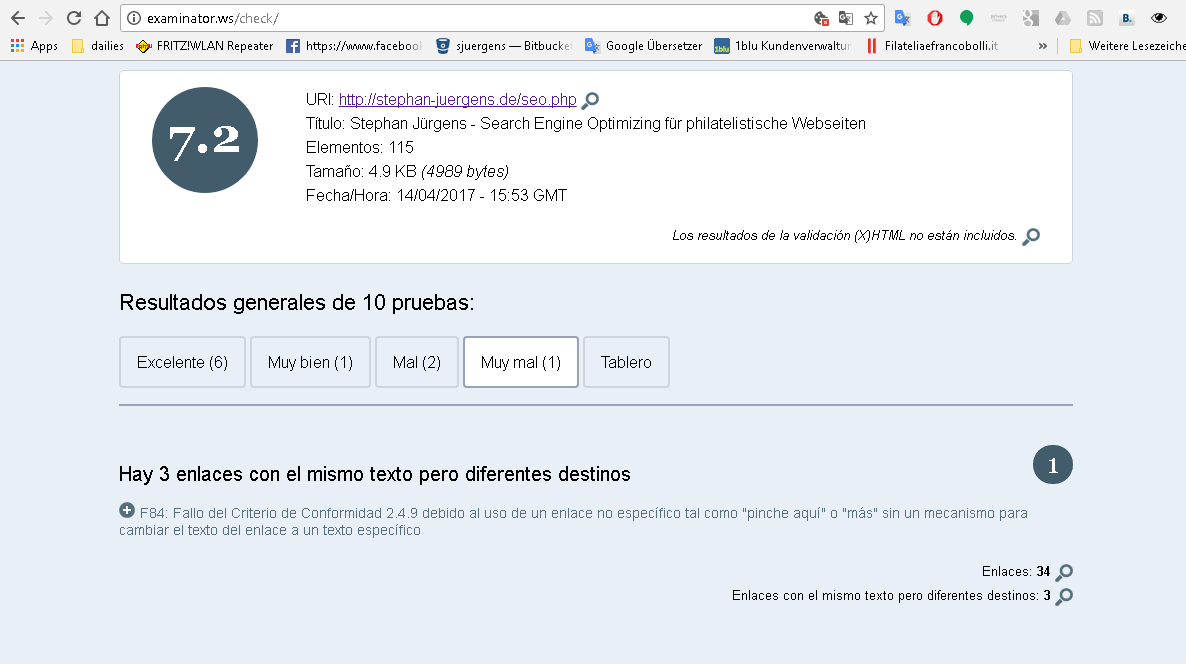

Stand September 2021 scheint der examinator.ws nicht mehr online zu sein.

Die BDPh-Richtlinien für Aussteller schlagen examinator.ws zur Validierung der HTML-Korrektheit vor. Sorry, dies leistet dieses Tool nicht, denn es macht mehr. Eine vom W3C Validator als "FEHLERFREI" (Document checking completed. No errors or warnings to show.) geprüfte Seite bekommt vom Examinator "nur" die Note 7.2 und 3 Fehler, davon einen als "sehr schwer" gekennzeichnet.

Screenshot eines Ergebnisses des Examitors zu meiner Webseite.

Konkret bemängelt er hier, dass ich an drei Stellen den gleichen Text verwende, um zu unterschiedlichen Stellen zu springen. Es handelt sich hier um die Rücksprünge von den Fußnoten - sorry, Suchmaschinen sollten Sprungmarken innerhalb einer Seite weitestgehend ignorieren, und für den menschlichen Leser sollte es eigentlich klar sein, dass man am Ende einer Fußnote wieder an die Stelle zurückspringt, von wo man zur Fußnote gesprungen ist ... natürlich könnte ich hier die Texte anpassen (al la "Zurück zum Aufruf von Fußnote 2").

Ein weiteres Beispiel für eine Abwertung durch examinator.ws: die Verwendung von Blocksatz. Auch dies wird als "muy mal" beurteilt, weil es Menschen mit eingeschränkten kognitiven Fähigkeiten gäbe, die Schwierigkeiten mit dem Verständnis der längeren Lücken haben, die beim Blocksatz entstehen können. Sicherlich ein interessanter Gedanke, aber ich vermute, dass Menschen, die dieses Problem haben, auch sonst wenig Freude an meiner Webseite haben werden.

Sorry, der BDPh emphielt hier ein Tool zur technischen Überprüfung der HTML-Programmierung, welches EINDEUTIG auch inhaltliche Entscheidungen des Autoren zur Grundlage der Bewertung heranzieht. Dass es dies auch noch ausschließlich in Spanisch - einer Sprache, die sicherlich alle Literaturjuroren des BDPh auch in feinen Nuancen verstehen - geschieht, macht für mich die Empfehlung des BDPhs für dieses Programm absolut unverständlich. Es besteht die Gefahr, dass die Juroren einfach nur die zu bewertenden Webseiten hier einfüttern und das Punktergebnis einfach abschreiben, ohne die Bedeutung dieses "Tests" verstanden zu haben. Und selbst wenn die Juroren - einige von ihnen habe ich ja durchaus als gewissenhafte Arbeitsbienen kennengelernt - sich mehr Arbeit machen, dass dieser Eindruck beim Aussteller entstehen kann, ist schon Schaden genug.

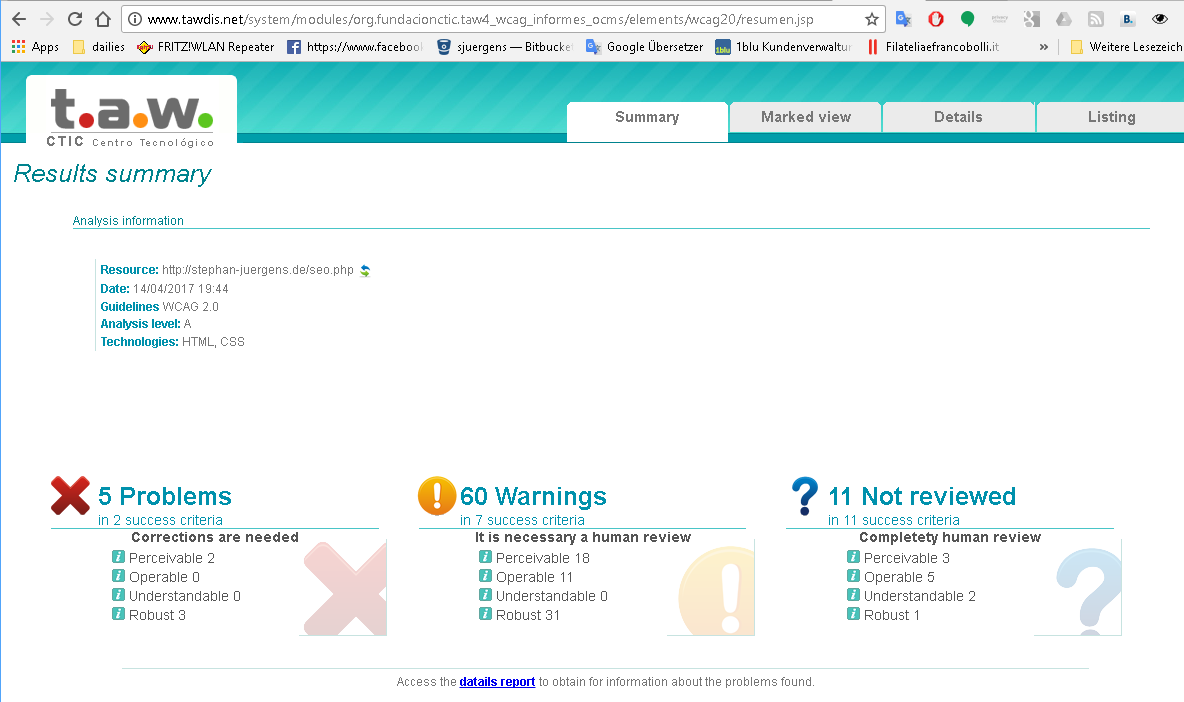

Stand September 2021 wirkt tawdis wesentlich moderner als auf dem Screenshot - ist aber noch genauso pingelig.

Das zweite vom BDPh vorgeschlagene Programm kommt ebenfalls aus dem spanischen Sprachraum, läßt sich allerdings auch auf englisch nutzen. Das Ergebnis meiner - wohlgemerkt vom W3C Validator als fehlerfrei geprüften Seite - sieht noch gravierender aus als beim Examinator.

Screenshot eines Ergebnisses von TAWDIS zu meiner Webseite.

Ein Blick in die "Datails" (Tippfehler in der englischen Version der Tawdis) zeigt, dass hier noch stärker als beim Examinator inhaltliche Bewertungen vorgenommen werden. So wird hier z.B. als "schwerer Fehler" bemängelt, dass zwei Überschriften der gleichen Ebene aufeinanderfolgen, ohne dass es Inhalt zwischen diesen beiden Überschriften gibt.

Insgesamt drei Anmerkungen/Fehler der unterschiedlichen Schwere bekomme ich für die Tatsache, dass ich vor der Überschrift (die als H1 getagt ist), den Autoren als H5 tagge. Wenn ich den Autoren mit den gleichen Tags unterhalb der Überschrift angebe, sind die beiden schwerer klassifizierten Fehlermeldungen verschwunden. Sorry, ein Juror, der als Begründung für eine schlechte Bewertung eines Arge-Rundschreibens oder einer Vereinzeitschrift angibt "Sie haben die Autoren oberhalb und nicht unterhalb des Titel der Artikel angegeben" würde zurecht übertriebener Kleingeist vorgeworfen. Ein Juror, der tawdis.net verwendet, macht dies vermutlich sogar unbewußt.

Damit man das nicht Falsch versteht: Ich empfinde die "Fehler", die Tawdis und der Examinator anmerken, durchaus überdenkenswert und habe einige davon umgesetzt, denn natürlich wirken sich auch inhaltliche Unschönheiten auf die Plazierung bei Google aus. Aber wollen wir wirklich alle philatelistischen Webbseiten stromlinienförmig im gleichen Design haben, oder dürfen auch individuelle Unterschiede bleiben?

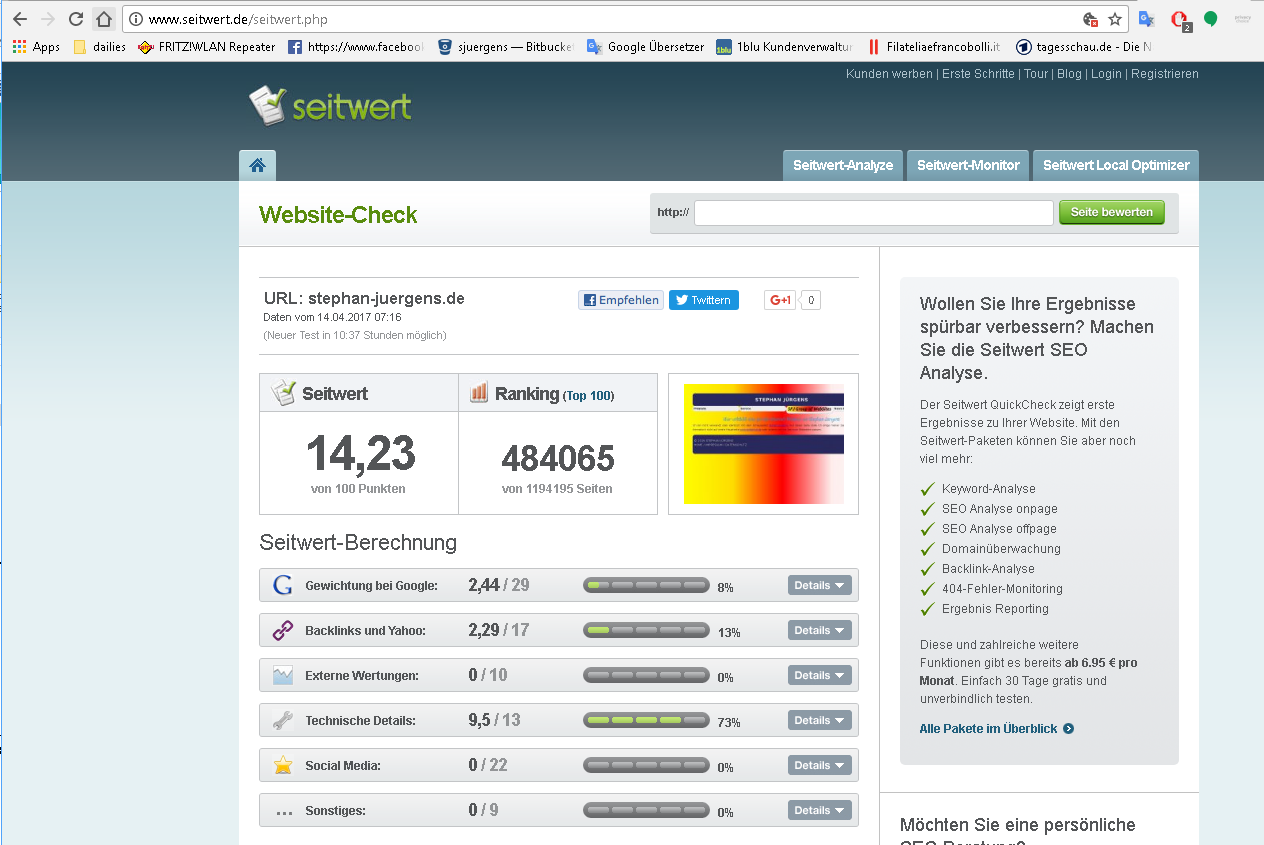

Stand September 2021 scheint seitwert.de den Besitzer oder die Geschäftspolitik gewechselt zu haben - es gibt zwar noch optisch die Möglichkeit, kostenfrei zu testen, in der Praxis funktioniert das aber nicht.

Die Autoren der "Handreichung" verweisen auf eine deutsche Webseite: www.seitwert.de. Die sollte m.E. also dazu führen, dass es weniger sprachlich bedingte Missverständnisse in der Bedienung und Auswertung gibt, als bei den oben genannten spanischen Programmen. Ein wesentlicher Unterschied fällt zu den drei vorherigen Programmen auf: konnte ich bei den bisher besprochenen Programmen gezielt eine einzelne Seite angeben, darf ich jetzt nur die Domain angeben - es wird also die "Titelseite" getestet, auf der ich traditionellerweise nur wenig Text und i.d.R. ein Bild habe. Dass genau dies dann auch bemängelt wird ...

Schwerwiegender ist, dass seitwert.de das kostenlose Lockangebot eines kostenpflichtigen Dienstes ist. Ohne zu bezahlen kann man nur EINE (nach Registrierung FÜNF) Webseite testen und muss zwischen dem ersten und dem zweiten Test mindestens 24 Stunden warten. Das heißt, um die Startseite einer Webseite mit einigen Fehlern zu korrigieren, muss man ein wenig Zeit mitbringen - und ein Juror kommt m.E. nicht darum, diesen Dienst zu bezahlen, wenn er alle Webseiten eines Literaturwettbewerbs in einem überschaubaren Zeitraum prüfen möchte.

Screenshot eines Ergebnisses von seitwert.de zu meiner Webseite.

Und 48 Stunden später: Screenshot eines Ergebnisses von seitwert.de zu meiner Webseite. Ich hatte mir einen SEO-Tipp zu Rate genommen und ein wenig Gehirnschmalz in die Gestaltung des <title>-Tag gesteckt: ich habe ihn von "Stephan Jürgens - Startseite" zu "Stephan Jürgens - Philatelie & mehr" geändert, was dazu führt, dass seitwert.de andere Abfragen zu Google und Yahoo schickt. Die Platzierungen dort haben sich m.E. so kurzfristig nicht geändert. Letzlich sollte es sich aber auswirken, da dieses zusätzliche Schlüsselwort im Seitentitel besser den "Markenkern" der Webseite trifft. Ferner habe ich das "meta description" Tag mit einem aussagekräftigeren Text versehen - mir war zwar klar, dass dies Tag wichtig ist, aber dass es GENAU dieser Text ist, der bei Google angezeigt wird, wenn eine Webseite unter den Treffen bei Google erscheint, habe ich erst wieder bei den Recherchen zu diesem Artikel wahrgenommen.

seitwert.de testet ganz anders als die bisher besprochenen Online-Tools: letzlich bündelt es die Ergebnisse von anderen Diensten. Die meisten dieser Dienste sind kostenfrei nutzbar, um einen Gesamteindruck zu gewinnen, oder aber die Ergebnisse langfristig automatisiert zu beobachten mag seitwert.de eine Hilfe sein. Für Seo-Profis kann sich die Investition in die bezahlten Versionen durchaus rechnen.

Gehen wir die einzelnen Punkte mal durch, da man hier durchaus einiges für die eigene SEO-Praxis lernen kann, ich aber auch Anmerkungen zu den Punkten machen kann, die für philatelistesche Webseiten verzichtbar sein könnten.

seitwert.de beginnt seine Analyse mit der Platzierung der Domain auf Google. Als ich das hier gezeigte Ergebnis gesehen habe, habe ich sofort nachgegooglet - mit den Suchbegriffen "stephan jürgens philatelie" liege ich auf dem ersten Platz der nichtbezahlten Suchergebnisse, 48 Stunden vorher war hier mit den Suchbegriffen "stephan jürgens startseite" nur ein "Sie sind bei Google gelistet, sind aber nicht unter den ersten 10."

Das ein 1. Platz nur zu 3,44 von 29 Punkten reicht - wieviel besser als Erster kann man denn noch werden?Der zweite Punkte "Google hat nur wenige Seiten im Index (9)" hat mich ein klein bisschen gewundert, war ich doch von nur 4 inhaltlichen Seiten ausgegangen, aber Google hat recht: mit den technischen Seiten wie Index, Sitemap, Impressum, ... hat diese Seite tatsächlich 9 (mit diesem SEO-Artikel 10) Seiten. Und natürlich ist die Analyse richtig, dass dies sehr wenige Seiten sind, aber Inhalte zu erzeugen kostet Zeit. Und auch gleich von 0 auf 100 zu gehen? Macht sicherlich nur Sinn wenn man die Resourcen hat, 100 längere Zeit zu halten. Sonst ist es sicherlich besser, nur gemächlich durch die Gegend zu tuckern. SEO ist Langstrecke, nicht Sprint.

Hier ist die Punkt-Wertung noch weniger verständlich: 2/2 auf der "Das ist gut" Seite und trotzdem nur 19% der Punkte. Andererseits: nur Backlinks von zwei Domains - dass könnte wirklich besser sein. Ein bisschen "Reklame" könntest Du für Deine Seite schon machen - eventuell mal bei Philaseiten und anderen Phila-Foren darauf hinweisen. Könnte ja auch inhaltliche Korrekturen Deiner Thesen und neue Kontakte geben. Vernetzung in der "realen Welt" ist ja auch nicht schlecht ...

Die Verbindung der Themen "Backlinks" und "Yahoo" ist nicht so ungewöhnlich, wie sie scheint: Yahoo - ein "Portal" welches älter ist als Google, ist als "Directory" angefangen, welches von einer (menschlichen) Redaktion betreut wurde. In diesen Zeiten war es ein Qualitätsmerkmal, bei Yahoo gelistet zu sein. Heute ist Yahoo eine Suchmaschine unter "ferner liefen", die ihre Suchergebnisse von Bing bezieht. Hier gelistet zu sein, heißt eigentlich nur es geschafft zu haben, die eigenen Seite bei Microsoft anzumelden. Bei Bing einen guten Platz zu bekommen, funktioniert nach den gleichen Kriterien wie bei Google: Inhalte und Fehlerfreiheit. Die Zeiten, dass Bing Webseiten, welche Microsoft-Technologien nutzten, besser bewertete sind vorbei. 4

Dem ein oder anderen mag ALEXA als die Siri von Amazon bekannt sein. Und falsch ist die Assoziation nicht, auch wenn es beim "Alexa Rank" um eine andere Seite der gleiche Software geht. Angefangen hat ALEXA - lange bevor sie von Amazon übernommen wurde - als kleine Symbolleiste, die im Internet-Explorer integriert werden konnte. Diese Symbol-Leiste schlug "ähnliche Webseiten" zur aktuell angezeigten Seite vor. Statt allerdings die "Ähnlichkeit" der Seiten zu bewerten, setzte Alexa im starken Masse auf die (unfreiwillige) Mitarbeit der Nutzer: wenn viele Nutzer nach den Besuch von "www.tagesschau.de" zu "www.heutejournal.de" wechselten, wurden Tagesschau und Heute-Journal als ähnlich angesehen, wenn dann allerdings viele Nutzer nach dem Heute-Journal ins Bett gehen, wurde auch "Bett" und "Heute-Journal" als "ähnlich" gewertet.

Konkret: gegen Alexa gibt es massive Datenschutzbedenken5, die u.a. darauf beruhten, dass Alexa JEDE Webseite, die ein Nutzer aufsucht, mitbekommt, egal ob der User sich nun für diese Seite "ähnliche Seiten" vorschlagen läßt oder nicht. Für den SEO, den es an dieser Stelle interessiert, wie häufig EINE Webseite aufgerufen wurde, ist die Frage, ob die Daten rechtskonform erhoben wurden, natürlich unwichtig. Ihn interessiert vielmehr die Zuverlässigkeit der Daten. Und an dieser gibt es berechtigte - in der Meßsystematik - liegende Zweifel. In Fachsprache formuliert: Alexa arbeitet mit einer NICHTREPÄSENTATIVEN Stichprobe, in welcher der englische Sprachraum deutlich über- und User z.B. mit Datenschutzbedanken, höheren Bildungsniveau, etc. deutlich unterrepräsentiert sind. Warum lieben SEOs Alexa trotzdem? In der Eigenwerbung schreibt Alexa: Improve SEO by Using Your Competitor's Website Traffic Statistics. Klar, die eigenen Statistiken kann man durch Analyse der Logfiles des Servers oder durch Tools wie GoogleAnalytics oder PIWIK viel besser und genauer bekommen, während diese Zahlen für fremde Webseiten in der Regel nicht zugänglich sind.6

Als nächstes gibt seitwert.de die Präsenz auf GoogleTrends an. Zu Google kommen wir später noch, Google Trends scheint ein Werkzeug zu sein, welches ich noch näher erkunden sollte, wo mir aber aktuell nicht klar ist, wie aus den Daten, welche dort bereitgestellt werden, Rückschlüsse darauf ziehen kann, wie sich eine konkrete Webseite schlägt. Dass Google Informationen darüber hat, wieviele Zugriffe welche Webseite (ungefähr) hat, glaube ich sofort, über GoogleAnalytics und GoogleAdwords werden den Kunden diese Daten ja zur Verfügung gestellt. Dass Google aber seine Firmengeheimnisse einfach so mit einem SEO-Unternehmen aus Deutschland teilt ... Ich jedenfalls lese aus den Daten, dass "Philatelie" um Weihnachten 2012 wesentlich wichtiger war als zur Zeit, und darüberhinaus in Frankreich populärer ist als in Deuschland oder der Schweiz ...

Mit "DomainAuthority" gibt seitwert.de den gleichnamigen Wert des Open Site Explorers des SEO-Dienstleisters MOZ.com. Dieser beruht auf der Anzahl der "Inbound Links" - hier wird also das Gleiche gemessen, wie bei den "Backlinks" weiter oben. ähnliche Ergebnisse sind also auch erwartbar.

"sehr wenige Probleme" ist natürlich ein schöner Euphemismus für "keine Fehler" - mehr zum W3C-Validator weiter oben. "Es ist genau ein h1 Überschrift vorhanden" klingt erstmal selbstverständlich, ist es aber nicht. Viele - z.B. vom Print oder der Grafik kommende - Webgestalter sehen in den H1-Überschriften lediglich eine Textzeile, welche anders dargestellt wird, als die Fliesstexte. Im Druck kann man dies auch so sehen, HTML ist allerdings eine Sprache zur SEMANTISCHEN Auszeichnung und weniger zur graphischen Gestaltung gedacht. Die Überschriften H1 bis H6 sind insofern als Gliederungseben des Textes zu sehen - und insofern ist es logisch, dass es nur eine Überschrift der Ebene 1 auf einer Seite geben darf. "Die Länge des Seitentitels ist optimal." - hier geht es um das Titel-Tag, nicht die Überschrift. Dass Titel-Tag wird z.B. in den Tabs des Browsers angezeigt oder als blau hinterlegter Link in den Google-Suchergebnissen - hat also eine zentrale Bedeutung. Im SEO-Bereich scheint sich eingebürgert zu haben, dass Title-Tags zwischen 60 und 70 Zeichen Länge gut sind, während viel Länge und viel kürzere als schlecht gelten. Wenn man nun eine Software benutzt, die Title-Tag und H1 Überschrift gleich halten, wie manche CMS-Systeme dies tun, heißt dies natürlich, dass man auch die Überschrift H1 in dieser Länge halten sollte.

"Die Meta-Description ist zu lang" - wie oben beschrieben, ist dies der Text, der bei Google als Seitenbeschreibung angezeigt wird, wenn man in den Suchergebnissen erscheint. Und auch andere Tools werten diese Kurzbeschreibung der Seite aus. Als Standard haben sich hier 170 Zeichen eingebürgert, aber seitwert.de scheint hier geringfügig längere Texte nicht als so negativ zu werten, wie Texte, die um die 70 Zeichen lang sind. (Warum soll ich den Gehirnschmalz aufbringen, eine 70-Zeichen Kurzbeschreibung und eine 170-Zeichen Kurzbeschreibung zu machen - nehmen wir doch für Beide den gleichen, ca. 60 Zeichen langen Text, ist eine Strategie, die zumindest bei seitwert.de zur Abwertung führt ...). "Die Seite enthält nur wenig Content" - hier rächt sich, dass seitwert.de nur die Titelseite einer Doamin auswertet. Diese besteht nämlich wirklich nur aus einem Satz und den Verweisen auf inzwischen vier Seiten, die alle längere Artikel enthalten. Mal gucken, ein wenig Inhalt könnte ich hier durchaus noch spendieren. Ob ich auf die 1800 Worte komme, die in SEO-Kreisen als besonders zielführend erachtet werden, bleibt abzuwarten.

Hier wertet seitwert.de die Likes, Shares und Comments aus, die es auf Facebook und google+ zu dieser Domain gibt. Webseiten, die also entgegen aller Datenschutzbedenken, "Like" oder "+1" Buttons aufweisen, haben hier prinzipiell die Chance bis zu 22 Punkte abzusahnen, wenn ihre LeserInnenschaft mitspielt.7

Wie schon gesagt - SEO ist Langstreckenlauf, nicht Sprint. Glücklicherweise ist Google nicht ganz so streng, was das Alter einer Webseite angeht, wie seitwert.de. Aber ein wichtiger Faktor ist dies schon.

Apropos Wikipedia - TODO Liste:

a) berühmt werden

b) Eintrag in der Wikipedia über mich suchen

c) dort meine Webseite verlinken

Wieviel Sinn b und c ohne a machen, bleibt auszuprobieren. Meiner Erfahrung nach dürfte ein Artikel über einen relativ

unbedeutenden Philatelisten aber recht schnell aus der Wikipedia rausgeschmissen werden - wegen mangelnder Relevanz

für das allgemeine Publikum. Die Wikipedia ist ja nicht das Telefonbuch ...

Nachdem wir uns nun recht ausführlich mit einigen Tools beschäftigt haben, die ich eher für den philatelistischen Hobby-Webmaster eher für ungeeignet halte, kommen wir nun zu einem Tool (bzw. einer Tool-Sammlung) welches ich auch für den Hobby-Webmaster für unumgänglich halte: die Google Webmaster-Tools, die seit 2015 Google Search Console heißen. Einfach bei Google nach Google Webmastertools suchen, dann gelangt man schon auf die richtige Seite.

Die Nutzung der Google Search Console setzt einen aktiven Google Account vorraus - Nutzer von GoogleMail, Google+ oder Youtube haben einen solchen, alle anderen können sich einen kostenlos anlegen. Geben Sie hier eine email-Adresse an, unter der Sie längerfristig zuverlässig erreichbar sind. Nach einer Einrichtungsphase müssen Sie nicht mehr zwingend regelmässig in die Webmastertools - bei wichtigen Problemen (z.B. wenn Google feststellt, dass Ihre Seite Viren verseucht ist) meldet Google sich mit einer Email. Unwichtige Probleme, über die Sie nicht per email informiert werden, können Sie weitgehend ignorieren. Die werden erst dann interessant, wenn Sie sich mit Ihrer Webseite nicht nur im Wettbewerb um Leser, sondern um Kunden befinden, d.h. wenn die Frage ob Sie sich auf Platz 1 oder auf Platz 2 der Google Suche befinden, über den kommerziellen Erfolg oder Mißerfolg Ihres Unternehmes entscheidet. Eine Frage, vor der Hobby-Webmaster meines Erachtens nicht stehen.

Nach der Anmeldung können Sie beliebig viele Webseiten (Domains) zu Ihrem Account hinzufügen - allerdings müssen Sie für jede einzelne Domain Google gegenüber nachweisen, dass Sie "Besitzer" dieser Webseite sind (d.h. dass Sie die Inhalte der Seite gestalten können). Am einfachsten geht dies, indem Sie von Google eine bestimmte Datei herunterladen (diese ist für jeden Google-Account unterschiedlich) und auf Ihre Webseite hochladen - ein Verlinken dieser Datei innerhalb der Webseite ist nicht nötig/sinnvoll - Google findet die Datei auch so. Die anderen Verfahren, wie z.B. dass Schreiben bestimmter Codes in die nicht sichtbaren Teile des HTML-Codes sind m.E. komplizierter in der Umsetzung. Dies muss aber jeder selber wissen.

Wenige Minuten nach der Bestätigung der Eigentümerschaft einer Webseite, bekommt man die erste Mail von Google - denn Google findet sicherlich etwas zu meckern - und wenn es nur wissen will, welches das bevorzugte Zielland für diese Webseite ist. Wenn Ihre Webseite sowohl mit als auch ohne vorgestelltens "www" bzw. sowohl verschlüsselt (https://) als auch unverschlüsselt (http://) zu erreichen ist, legen Sie alle Varianten in den Webmastertools an. Google fordert Sie dann per email auf, sich zu entscheiden, welches davon Ihre "bevorzugte" Variante ist. Diese Entscheidung sollte konform gehen mit dem "canonical link" der jeweiligen HTML-Seiten. Diese "canonical links" werden von Google ausgewertet, trotzdem legt Google Wert darauf, dass Sie dies in der Search Console "bestätigen" und nervt Sie mehrere Wochen mit emails, wenn Sie dies nicht tun.

Ansonsten werden Sie von den Webmastertools nur denn hören, wenn sich "Tote Links" oder "grobe Schnitzer" im Html-Code der Seite befinden. Aber alleine die Tatsache, dass Sie Ihre Webseite nicht mehr selbst auf Virenbefall oder veraltete CMS-Versionen überwachen müssen, ist die Mühe der Anmeldung wert.

Screenshot der google Search Console zu meiner Webseite. Auf den ersten Blick sieht alles in Ordnung aus. Ab und an verirrt sich mal jemand aus der Google Suche auf meine Seite, es gibt keine Crawling Fehler und keine Nachrichten. Nach der Lektüre des "Warum sollte ich eine SiteMap einreichen?" habe ich entschieden, dass dies für diese Domain nicht notwendig ist, da ja ALLE Unterseiten mit einem Klick von der Hauptseite aus zu erreiche sind, die Sitemap also keine Links enthalten würde, die nicht auch auf der Hauptseite verlinkt sind. Für Seiten mit mehreren Ebenen würde ich diese Entscheidung sicherlich anders treffen. Ob man die Sitemap dann in der Google Search Console einträgt oder aber den Weg wählt, diese in den Meta-Tags der Startseite zu verlinken, ist die Frage, ob man nur Google "bedienen" will, oder ob man auch den anderen Suchmaschinen faire Startbedingungen geben will. Yandex aus Russland und Baidu aus China sind zwar für eine deutschsprachige Philatelie-Webseite eventuell verzichtbar, kommen aber in der gleichen Regelmässigkeit die Webseite besuchen wie Google und Bing. Und im Netz sind noch Dutzende (wenn nicht Hunderte) weitere Datensammler unterwegs, die regelmässig oder unregelmässig vorbeikommen.

Trotzdem sollte man sich ab und an durch die einzelnen Gruppen klicken - so ein oder anderer nützlicher Tipp ist hier zu entdecken. "Strukturierte Daten", "Rich Cards" und "Data Highlighter" kommen für meine Webseite nicht in Frage, dies ist für Vereinswebseiten, die regelmässige Termine, oder Händler, die Waren anbieten, anders. In die "Accelerated Mobile Pages" habe ich mich ein wenig eingelesen, dann aber beschlossen, dass dies für meine Webseiten keine Priorität hat. Für Webseiten, deren Nutzer hauptsächlich "von unterwegs" auf die Webseite zugreifen, ist diese Technik allerdings wichtig - und Google bietet hier einen recht einfachen Weg die korrekte Funktion zu überwachen. Unter HTML-Verbesserungen finden sich Hinweise auf kleinere Probleme mit dem HTML-Code der Seite, in diesem Fall der Hinweis, dass das Meta-Description Tag u.a. für Startseite und Impressum zu kurz ist. Startseite ist korrigiert, nur Google hat es noch nicht mitbekommen, und beim Impressum werde ich dass nicht ändern. Für ein Impressum fällt mir keine längere Kurzbeschreibung ein, als das Wort "Impressum". Mut zur Lücke - und ein wichtiger Fehler ist dies ja nicht, sonst wäre ja eine email gekommen.

Unter Suchanfragen kann man u.A. sehen, in welchen Suchanfragen man wie häufig vorkommt. Und auf welchem Platz. Man kann diese Daten vielfältig filtern. Ein Hobby-Webmaster wird sich hier eher amüsieren, für einen Profi könnte diese Liste der Hinweis sein, dass Google einem im Bereich "Sonderstempel des Deutschen Reichs" einge gewisse Kompetenz zubilligt, die allerdings bislang meines Erachtens in der entsprechenden Seite nicht vorkommt. Dies könnte man z.B. durch eine eigene Unterseite zum Thema "Sonderstempel des Deutschen Reichs" ausbauen. Gleiches gilt für den Schauspieler und Sänger Stefan Jürgens (u.a Soko Wien, früher beim Tatort Berlin und bei RTL Samstag Nacht), wo meine Webseite auf einem der vorderen Plätze landet. Ansonsten scheint es wohl in Bad Salzungen Probleme mit dem Kartoffelkäfer zu geben und in Giessen und Bielefeld scheint jemand einen seriören Briefmarkenhändler zu suchen ... interessant ist auch die Verteilung der 253 Suchanfragen auf die Länder, aus denen sie kommen - nur 142 kommen aus Deutschland, die anderen 111 verteilen sich auf 49 Länder, wobei Liechtenstein und die Schweiz je einmal und Österreich keinmal vertreten sind. Das heißt, obwohl diese Seite komplett in Deutsche gehalten ist, und für Google eindeutig das Zielland Deutschland eingetragen ist, kommen gute 2/5 der Suchanfragen, in denen meine Seite gelistet wird, aus dem nichtdeutschsprachigen Ausland.

Unter "Links zu Ihrer Webseite" kann man die Webseiten sehen, von denen es BackLinks gibt. Die oben besprochenen Dienste liegen also nicht falsch, wenn sie auf Backlinks achten. Allerdings hatte Google noch eine weitere - recht obscure - Webseite gelistet, welche bei den oben angesprochenen Tools nicht aufgeführt war. Unter Nutzerfreundlichkeit auf Mobilgeräten erfahre ich, dass eine der insgesamt 9 Seiten dieser Domain das Problem hat, dass dort die Inhalte breiter sind als die Bildschirmbreite (auf Mobilgeräten). Muss ich gelegentlich mal überarbeiten ...

"Google Index" zeigt google an, wievele Seiten (der Domain) es im Index hat, unter Crawling kann man zum einen sehen, wie häufig Google zu Besuch kommt, und zum anderen ob es dabei Probleme gegeben hat. Für diese kleine, sich nur selten ändernde Webseite werden täglich, 2-3 Seiten abgerufen, wenn Google dabei allerdings eine Änderung bemerkt, werden auch schon mal mehrere Tage hintereinander 100 bis 150 Seiten (google zählt hier wohl eingebette Bilder als eigene Seiten) abgerufen. Und alle 10 bis 14 Tage werden um die 10-15 Seiten abgerufen - was ich aber nicht mit Änderungen an meiner Webseite in Verbidung bringen kann. Ansonsten kann ich wahrnehmen, dass es ca. 5-7 Tage dauert, bis Änderungen, die ich an der Webseite vornehme, im Index auftauchen. Es ist bekannt, dass Google diejenigen Seiten, die sich häufiger ändern, auch häufiger besucht, und auch die Seiten, die häufiger aufgerufen werden, häufiger beehrt.

Microsoft hat mit den "Bing-Webmastertools" ein nicht nur sehr ähnlich benanntes, sondern auch inhaltlich sehr ähnliches Tool im Programm. Interessanterweise kommt bei einer Bing-Suche nach "webmastertools" die Google-Variante auf Platz 1 und 2, während das Bing-eigene Produkt erst auf Platz 3 kommt. D.h. selbst Bing hält hier Google für das relevantere Tool. Auf eine Besprechung verzichte ich hier also, nicht ohne anzumerken, dass Hobby-Webmaster die Bing-Variante auf jeden Fall allen Bezahlalternativen vorzuziehen sollten. Die bei Google und/oder Bing kostenlosen Leistungen gehen weit über das hinaus, was ein Hobby-Webmaster benötigt.

Einige der oben besprochenen Dienste bieten an, sich aktualiserende "Benotungsbuttons" o.ä. auf der eigenen Webseite einzubinden. Kann man machen, muss man aber nicht. Aus einem Gefühl von Fairniss heraus, könnte man die damit verbundene kostenlose Werbung als Bezahlung bzw. ein Geschäft auf Gegenseitigkeit betrachten. Andererseits müssen Sie bedenken, dass Sie damit einen Teil Ihres "Linkjuice" auf ein SEO-Unternehmen übertragen. Deren Geschäft ist es, Webseiten zu promoten, d.h. jeder Link von einer Webseite berührt INHALTLICH deren Kerngeschäft (und dies wird von Google auch so gewertet), während das Kerngeschäft einer philatelistischen Webseite die Philatelie ist. Ein Satz wie "Ich habe bei der Gestaltung dieser Webseite von ... helfen lassen" trägt wenig zur Steigerung Ihrer Kompetenz im "Kerngeschäft" bei, wenn es sich nicht um jemanden handelt, der auch in diesem Bereich unterwegs ist ...

In diesen Artikel habe ich mir einige SEO-ONLINE-Tools angeschaut. In einem zweiten Artikel geht es um SEO-OFFLINE-Tools.

Daniel Berger: Erster bei Google. Wie Google die Regeln für die Suchmaschinenoptimierung vorschreibt. In: c't magazin für computer technik 19/2019 vom 3.9.2016.

Obwohl Fußnoten eher ein Hilfsmittel des klassischen Literaturschaffens sind, die im Printbereich sinnvoll sind, und die im Online-Bereich eher stören, sehe ich mich, um den Lesefluß nicht vollständig unmöglich zu machen, gezwungen, Fußnoten einzusetzen.

1) In einem ersten Entwurf hatte ich hier "SEO Tools" stehen - Ich befürchte aber, dass es Programme gibt, die genau so heißen - hier ist noch die Gesamtheit der Tools gemeint, die für SEO eingesetzt werden. zurück zum Text.

2) Für die Professionalität der Autoren der BDPh Richtlinien spricht, dass die beiden von Ihnen empfohlen Programm auf Spanisch arbeiten (eines hat allerdings eine englische Variante). Dafür fehlt der offizielle Validator des W3-Consortiums (validator.w3.org), also von dem Gremium, welches den HTML Standard definiert, dessen "technisch einwandfreie Programmierung" zu überprüfen, die Aufgabe der Tools ist, welche die BDPh Autoren angeben. zurück zum Text.

3) Suchmaschinen bewerten für Ihr Ranking AUCH das Aussehen einer Seite, dies aber teileweise unter anderen Gesichtspunkten als der menschliche Betrachter oder der Designer. Dies geschieht teilweise unter dem Gesichtspunkt der Barierrefreiheit (so sollen z.B. rot-grüne Farbverläufe zu Abwertungen führen, weil sie bei Farbenblinden teilweise extreme Probleme hervorrufen können). Insgesamt ist beim Webseiten-Design auf gute Kontraste zu achten. Weißer Text auf weißem Hintergrund - oder auch generell Text in der Hintergrundfarbe - ist heute für das Ranking in Suchmaschinen sehr negativ - es gab eine Zeit, da war dies recht beliebt, um mittels beliebter Stichworte unbeliebte Inhalte (sprich Werbung) an den Mann zu bringen. zurück zum Text.

4) Microsoft hat dies m.E. nie absichtlich getan. Die Besserbewertung dieser Technologien beruhte m.E. darauf, dass Microsoft diese Techniken besser verstand als die Konkurrenz und deshalb die Inhalte besser extrahieren konnten. Da die Bedeutung proprietär Technologien im Web stark zurückgegangen ist - statt dessen dominieren "offene Standards" wie HTML 5 und CSS - sind die prinzipiellen Unterschiede zwischen den einzelnen Suchmaschinen und Browsern nahezu verschunden. Die Frage ist letzlich welcher "Datenkrake" man das eigene Suchverhalten und die daraus generierbaren Profite übermitteln möchte. zurück zum Text.

5) vergl. Seite "Alexa Internet". In: Wikipedia, Die freie Enzyklopädie. Bearbeitungsstand: 13. März 2017, 21:51 UTC. URL: https://de.wikipedia.org/w/index.php?title=Alexa_Internet&oldid=163558956 (Abgerufen: 16. April 2017, 08:54 UTC) zurück zum Text.

6) Da ich die verschiedenen SEO-Tools im Rahmen der Recherche für diesen Artikel auch ausprobiere, mangels Listings meiner Seite bei Alexa aber nur einen unvollständigen Eindruck bekomme, hier Screenshots von Alexa mit den Daten zu bdph.de.

Danach bewegt sich der Rank von BDPh.de in den letzen Monaten zwischen 750.000 und 1 Mio - mit absteigender Tendenz. Und auch in Deutschland gibt es aktuell über 77.000 Webseiten, die populärer sind als der BDPh ...

Überraschenderweise kommen mehr als 80% der Besucher aus Deutschland ...

Die Benutzer verlassen zu über 70% die Seite schon nach der Ansicht von nur einer Seite BDPh.de, haben also genug von dem Verein. Da die Benutzer im Durchschnitt aber 2,1 Seiten ansehen und weit über zwei Minuten auf der Seite bleiben, müssen die anderen 28% der Benutzer die Seite schon recht intensiv nutzen.

Amüsanter wird es hier: knapp 50% der Besucher werden von einer Suchmaschine zum BDPh geleitet (die anderen haben den BDPh entweder in ihren Favoriten gespeichert, können die URL auswendig oder folgten dem Link auf irgendeiner Webseite ...). Aber: knapp 10% der Nutzer, die von einer Suchmaschine zum BDPh kamen, hatten "DELCAMPE" gesucht. Da ist wohl eine Entwicklung an mir vorbeigegangen ... "bédéphile" sind übrigens die (französischen) Comicliebhaber - damit hätten wir einen Teil derjenigen identifiziert, die schon nach einer Seite den BDPh verlassen ...

Laut Alexa verweisen insgesamt 137 Webseiten auf den BDPh, von denen SourceForge und die Bildzeitung die wichtigsten sind. Vielleicht kann mir mal einer aus der Linux/GNU Fraktion erklären, welchen Zusammenhang es zwischen Open-Source Software und dem BDPh gibt. Ausser das man beide Zielgruppen als Nerds bezeichnen kann, fällt mir da konkret nichts ein ...

7) Eine datenschutzkonforme Lösung für das Einbinden des "Facebook Like Button" und anderen "Social Media" stellt c't unter heise.de/-2463330 bereit. zurück zum Text.